寧夏眼動追蹤硬遠紅外模組

眼動追蹤技術憑借其非侵入性和高精度特性,已成為神經退行性疾病早期篩查的關鍵工具。以阿爾茨海默病為例,患者在執行視覺搜索任務時,其眼動模式會呈現***異常——注視點分布分散、掃視路徑混亂,且對復雜圖像的凝視時間***短于健康人群。華弘智谷通過自研的三維視線人眼建模技術,將眼動追蹤精度提升至°以內,并開發出便攜式醫療級眼動儀。該設備已應用于深圳多家三甲醫院,通過分析患者凝視動態熱力圖,輔助醫生區分阿爾茨海默病與血管性癡呆。在帕金森病研究中,華弘智谷與北京協和醫院合作,利用高頻眼動儀捕捉患者啟動掃視的延遲特征,結合虹膜識別技術排除年齡相關眼部病變干擾,使診斷準確率提升至92%。此外,其眼動追蹤系統還支持自閉癥兒童社交注視行為分析,通過量化面部區域注視時長占比,為個性化干預方案提供數據支撐。 在數碼產品設計中,眼動追蹤技術能記錄用戶觀看外殼時的移動軌跡和停留時間,幫助設計師優化結構。寧夏眼動追蹤硬遠紅外模組

在自動駕駛的實驗室里,工程師們把眼動追蹤鏡頭偽裝成儀表盤上方的一條黑色裝飾條,毫不起眼,卻能在。當系統發現駕駛員的瞳孔在連續三秒內沒有掃視后視鏡或側窗,而是呆滯地盯著中控屏上的短視頻時,車輛會立即觸發“接管預警”:座椅震動、提示音響、方向盤上的LED燈帶從冰藍色驟變為橙紅色。眼動追蹤在此刻不僅是安全鎖,更像一位嚴厲卻體貼的副駕,它記錄下了駕駛員眨眼頻率的微妙變化——從每分鐘15次驟降到7次——并由此推斷疲勞程度已超過算法設定的閾值。后臺的深度學習模型把這次數據回傳至云端,與其他三百萬名司機的夜間駕駛眼動追蹤樣本進行比對,**終生成一份個性化的疲勞畫像,推送至用戶手機:建議休息20分鐘,播放節奏為90BPM的輕音樂,并將座艙溫度下調兩度。這套系統的野心不止于提醒,它想讓每一次目光的游移都成為優化人機交互的燃料,讓眼動追蹤從冷冰冰的傳感器升維成“會呼吸的行車伴侶”。 陜西眼動追蹤異常眼動熱力圖顯示,電商商品詳情頁中,用戶視線在價格區域的停留時間比促銷標簽長2.3倍,指導頁面布局優化。

司法取證領域正因眼動追蹤而產生“認知測謊”的新分支。斯坦福大學法學院的研究表明,當證人回憶真實經歷時,其眼球運動軌跡的混沌指數(Lyapunov指數)比編造證詞時高37%,這種差異源于真實記憶提取時海馬體與額葉眼動區的神經振蕩同步性。現在,某些州法院已開始采納“眼動證據”,但爭議在于:當辯護律師通過訓練使被告掌握“反追蹤”技巧(如刻意制造不規律掃視)時,這種技術的可靠性就會崩塌。更根本的質疑來自神經法學派:如果自由意志不過是眼球運動的副現象,那么基于眼動的“認知指紋”是否侵犯了反對自我歸罪的***權利?

2024 年 6 月深圳第五屆 AR/VR 產業論壇上,華弘智谷副總經理梁立偉在主題演講中***披露,公司已完成“虹膜+眼動”雙引擎的 XR 標準化模組量產,單目重量降至 3.2 g,采樣延遲控制在 5 ms 以內,可直接嵌入國產 AR 眼鏡鏡腿,實現注視點渲染與身份認證一次性完成,引發多家終端廠商現場簽約;論壇結束后,該模組被多家媒體評為“2024 年度 XR 交互突破技術”2024 年 10 月,華弘智谷攜 ZG-Med 醫療眼動系統在“第二十六屆全國眼科學術大會”亮相,現場演示了針對嬰幼兒的“無標定注視偏好”范式:設備利用虹膜特征作為空間錨點,30 秒完成 6 個月大嬰兒的***眼動校準,并實時輸出視敏度曲線,中山眼科醫院當場宣布將該系統納入新生兒篩查路徑,預計每年可服務 8 萬名早產兒,相關報道被《中國眼科網》連續三天置頂在智能駕駛領域,該公司技術可實時監測駕駛員眼球運動。

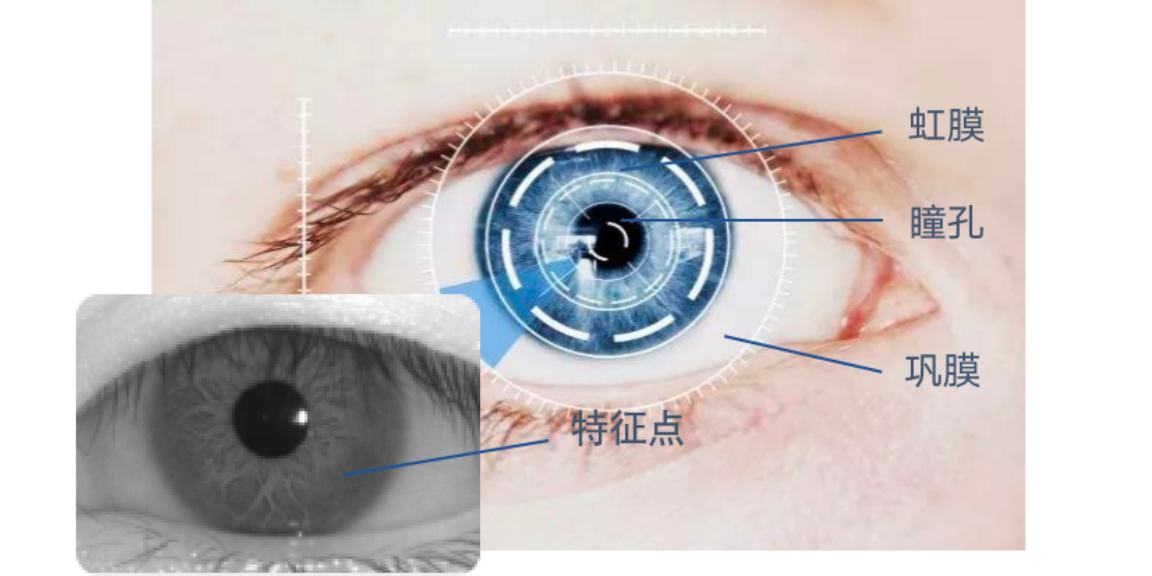

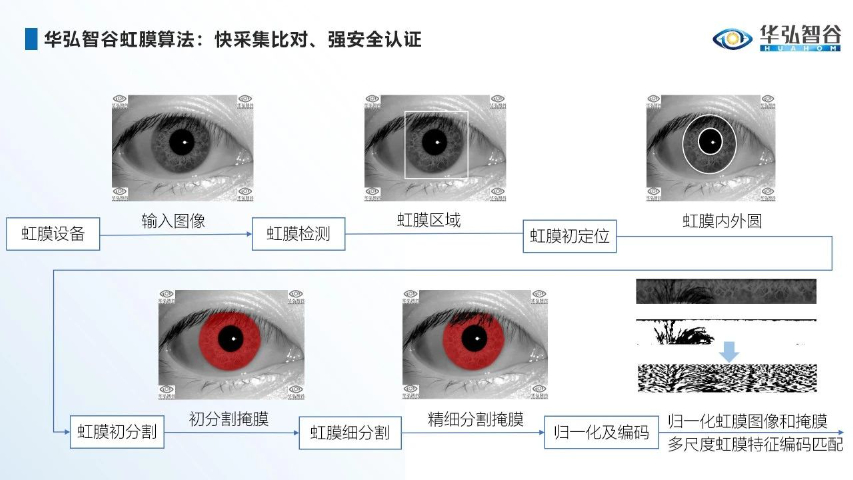

眼動追蹤技術正以“視線即交互”的顛覆性邏輯重塑XR設備的人機交互邊界。以華弘智谷為例,其自研的虹膜眼動二合一方案通過將虹膜識別與眼動追蹤深度融合,在XR設備中實現了三大突破:其一,基于用戶虹膜特征的***性,構建了多用戶無感切換系統,不同用戶佩戴設備時可自動調用個性化配置;其二,通過動態瞳距調節算法,將設備適配誤差控制在,***降低眩暈感;其三,結合注視點渲染技術,在工業設備維護場景中實現40%的GPU負載優化,使某能源企業的設備巡檢效率提升37%。這種技術融合不僅體現在硬件層面,更延伸至交互邏輯重構——在華弘智谷參與制定的XRMA聯盟標準中,明確要求眼動交互延遲需低于30ms,推動行業從“功能疊加”向“體驗**”躍遷。 眼動追蹤技術主要基于眼睛的生理特征和光學原理。廣東眼動追蹤圖片

利用眼動指標可綜合評估運動疲勞對不同時段閱讀能力的影響。寧夏眼動追蹤硬遠紅外模組

眼動追蹤技術正在賦能智慧農業的精細化發展。華弘智谷的AgriEye系統通過無人機搭載的多光譜眼動追蹤模塊,模擬植物學家觀察作物的視線軌跡,結合AI圖像識別技術量化評估植株健康狀態。在山東壽光的蔬菜大棚試點中,系統發現經驗豐富的農戶在檢查番茄病害時,視線會優先聚焦葉片背面和莖稈分叉處,且對黃化曲葉病毒的典型癥狀(葉片卷曲、顏色深淺不均)的凝視熱點分布與實驗室檢測結果高度吻合。基于此,AgriEye系統開發了“**視線模型”,通過訓練神經網絡學習農戶的觀察路徑,使AI病害識別的準確率從78%提升至92%。此外,該系統還可分析蜜蜂采蜜時的飛行軌跡,通過眼動級精度的運動追蹤,優化果園授粉樹種的布局,使蘋果坐果率提升18%。寧夏眼動追蹤硬遠紅外模組

- 江西什么叫虹膜識別 2025-10-25

- 上海眼虹膜識別 2025-10-25

- 內蒙古帶虹膜識別 2025-10-25

- 南山區自研技術虹膜識別供應商家 2025-10-25

- 廣東開源虹膜識別 2025-10-25

- 江蘇虹膜識別技術具有特點 2025-10-25

- 江蘇虹膜識別白內障 2025-10-25

- 江蘇虹膜識別 眼睛 2025-10-25

- 廣東虹膜識別原理 2025-10-25

- 中國澳門s8的虹膜識別 2025-10-25

- 廬江系統外呼系統標準 2025-12-06

- 鈦合金火災機床自動滅火裝置解決方案 2025-12-06

- 西藏辦公室客流統計系統 2025-12-06

- 寶山區本地云客服服務熱線 2025-12-06

- 江蘇公交刷卡機廠家直銷 2025-12-06

- 上海DTSS光纖系統購買 2025-12-06

- 肥西定做外呼系統服務熱線 2025-12-06

- 江西工業FW-C101濾毒盒 2025-12-06

- 宿遷保安公司推薦 2025-12-06

- 艦載無線遙控器價格 2025-12-06